서론

최근 AI 세상에서 신흥강자로 떠오른 언어 모델로 인해 시끌시끌 합니다. 바로 DeepSeek(이하 딥시크) 라는 언어 모델입니다. 딥시크(DeepSeek/深度求索,심도구색)는 중국의 헤지펀드 회사인 '환팡퀀트(幻方量化)' 소속의 인공지능 연구 회사 이름이기도 하며, 언어 모델의 이름이기도 합니다.

딥시크는 OpenAI의 ChatGPT, Meta의 LLaMA와 같은 대규모 언어모델(LLM; Large Language Model)입니다. ChatGPT나 LLaMA 같은거랑 같다면, 이게 뭐가 대수냐고 이 난리냐? 라고 궁금해하실 수 있습니다. 현재 기준(2025년 1월 말)으로 딥시크는 ChatGPT와 LLaMA, 클로드 및 제미나이보다 훨씬 뛰어난 성능을 자랑하고 있습니다. 성능은 좋을 수 있습니다. 여기서 한 가지 더 놀라운 것은, 2024년 12월에 발표된 DeepSeek-V3 모델은 ChatGPT, 클로드, 제미나이와 경쟁할 수 있는 수준의 성능으로 알려졌는데, 고작 80억원이라는 적은 비용으로 개발되었다고 알려져서 큰 충격에 빠졌습니다. 더 좋은 장비(그래픽카드)와 더 많은 돈(인재들의 인건비 등)을 들이면 훨씬 더 훌륭한 결과물(더 진화된 LLM)이 나올 것이라는 고정관념을 깨버린 것입니다.

딥시크는 아웃풋으로 성능을 증명해냈기 때문에, AI 업계에 찬바람이 불지 않을까.. 하는 우려도 있습니다. 지금 이 글을 쓰는 오늘(2025년 1월 27일) 기준으로 미국 나스닥 프리마켓에서 엔비디아는 -10퍼센트 하락을 하고 있습니다. 그 외 테크주들도 큰 하락 중이네요.

딥시크는 웹에서 쉽게 사용해볼 수 있습니다. 다음의 링크( https://chat.deepseek.com/sign_in )에서 구글 로그인 후 웹에서 사용해보거나, 아래의 플랫폼별 링크에서 앱을 다운로드 받아서 사용해볼 수 있습니다.

- 안드로이드 DeepSeek 앱 다운로드 : https://play.google.com/store/apps/details?id=com.deepseek.chat

- iOS DeepSeek 앱 다운로드 : https://apps.apple.com/kr/app/deepseek-ai-%EC%96%B4%EC%8B%9C%EC%8A%A4%ED%84%B4%ED%8A%B8/id6737597349

DeepSeek - AI 어시스턴트 - Google Play 앱

지능형 AI 어시스턴트

play.google.com

DeepSeek - AI 어시스턴트

DeepSeek의 공식 AI 어시스턴트와 원활한 상호작용을 무료로 경험해보세요! 600B 이상의 파라미터를 가진 획기적인 DeepSeek-V3 모델로 구동되는 이 최첨단 AI는 글로벌 표준을 선도하며 다양한 벤치

apps.apple.com

그런데 한 가지 문제가 있습니다. DeepSeek는 중국 회사입니다. 이게 무슨 문제냐구요? 수집하는 자료가 정말 많습니다.

DeepSeek의 프라이버시 정책

DeepSeek는 중국에서 서비스하는 대규모 언어 모델입니다. 웹이나 앱으로 사용하는 DeepSeek의 경우는 수집하는 자료가 아주 많습니다. DeepSeek의 프라이버시 정책에 따르면, 아래 내용이 수집된 후 중국 서버에 저장된다고 합니다. ( https://chat.deepseek.com/downloads/DeepSeek%20Privacy%20Policy.html 내용을 구글 제미나이로 요약했습니다)

- 사용자가 제공하는 정보 (Information You Provide)

- 프로필 정보: 계정 생성 시 제공하는 생년월일(해당하는 경우), 사용자 이름, 이메일 주소 및/또는 전화번호, 비밀번호와 같은 정보.

- 사용자 입력: 서비스 사용 시 사용자가 제공하는 텍스트 또는 오디오 입력, 프롬프트, 업로드된 파일, 피드백, 채팅 기록, 또는 기타 콘텐츠.

- 문의 시 제공하는 정보: 고객 지원 문의 시 제공하는 신분증 사본 또는 연령 증명, 서비스 사용에 대한 피드백이나 문의 사항, 서비스 약관 또는 기타 정책 위반 가능성에 대한 정보. - 자동으로 수집되는 정보 (Automatically Collected Information)

- 기술 정보: 서비스 접속 시 수집되는 기기 모델, 운영 체제, 키 입력 패턴 또는 리듬, IP 주소, 시스템 언어 등의 기기 및 네트워크 연결 정보. 또한 충돌 보고서 및 성능 로그를 포함한 서비스 관련, 진단 및 성능 정보도 수집됩니다. 기기 ID와 사용자 ID가 자동으로 할당되며, 여러 기기에서 로그인하는 경우, 기기 ID와 사용자 ID와 같은 정보를 사용하여 기기 간 활동을 식별하여 원활한 로그인 경험을 제공하고 보안을 유지합니다.

- 사용 정보: 사용한 기능 및 수행한 작업과 같이 서비스 사용과 관련된 정보.

- 쿠키: DeepSeek와 서비스 제공자 및 비즈니스 파트너는 쿠키 및 기타 유사한 기술(예: 웹 비콘, 플래시 쿠키 등)을 사용하여 자동으로 정보를 수집하고, 서비스 사용 방식을 측정 및 분석하고, 서비스 사용 경험을 향상시키고, 서비스를 개선합니다. 쿠키는 서비스가 특정 기능과 기능을 제공할 수 있도록 합니다. 웹 비콘은 "픽셀 태그" 또는 "투명 GIF"라고도 하는 이미지에 포함된 매우 작은 이미지 또는 작은 데이터 조각으로, 쿠키, 페이지를 본 시간 및 날짜, 픽셀 태그가 있는 페이지에 대한 설명, 컴퓨터 또는 장치에서 유사한 정보를 인식할 수 있습니다.

- 결제 정보: 선결제를 위한 유료 서비스를 이용할 때, 주문, 결제, 고객 서비스, 애프터 서비스와 같은 서비스를 제공하기 위해 결제 주문 및 거래 정보를 수집합니다. - 기타 출처를 통해 얻는 정보 (Information from Other Sources)

- 로그인, 가입 또는 연결된 서비스: 사용 가능한 경우, Apple 또는 Google과 같은 타사 서비스를 사용하여 서비스에 가입하거나 로그인하거나 계정을 타사 서비스에 연결하도록 선택하면 액세스 토큰과 같은 해당 서비스에서 정보를 수집할 수 있습니다.

- 광고, 측정 및 기타 파트너: 광고주, 측정 및 기타 파트너는 사용자와 사용자가 서비스 외부에서 수행한 작업에 대한 정보를 DeepSeek와 공유합니다. 여기에는 사용자가 온라인 또는 오프라인에서 구매한 제품 또는 서비스를 포함하여 다른 웹사이트와 앱 또는 매장에서의 활동이 포함됩니다. 이러한 파트너는 광고용 모바일 식별자, 해시된 이메일 주소 및 전화번호, 쿠키 식별자와 같은 정보도 공유하며, DeepSeek는 이를 사용하여 사용자와 사용자의 서비스 외부 활동을 매칭합니다.

내용들을 보니까 조금 찜찜합니다. 빠르고 정확한 분석을 위해서 코드나 자료를 올리면 큰일날 것 같은 느낌입니다. 그렇다면 우리는 DeepSeek를 사용하지 못하는 것일까요? 아닙니다. DeepSeek는 MIT 라이센스로 '오픈' 되었습니다. MIT 라이센스는 출처만 남기면 누구나 상업적으로 사용할 수 있는 정책이거든요. 따라서 DeepSeek의 언어 모델은 배포된 상태이며, 외부 인터넷과 연결되지 않는 상태로(로컬에서) 사용할 수 있습니다. DeepSeek 언어 모델을 로컬에서 단독 사용한다면 무슨 자료나 질문을 올리더라도 중국 서버에 저장되지 않는 다는 뜻입니다.

이제 이 방법을 설명드리고자 합니다.

사전 준비

DeepSeek-R1 언어 모델을 로컬 환경에서 사용하기 위해선, 아래의 사전 준비가 필요합니다. (윈도우 OS 기준)

- 엔비디아 그래픽카드 장착 (RTX 30 시리즈 이상 / VRAM 8GB 이상 권장)

- Docker Desktop 설치 ( https://www.docker.com/products/docker-desktop/ )

→ 이 때 Docker-Compose가 같이 설치됨

→ 설치 후 실행 Ollama 설치 ( https://ollama.com/ )→설치 후 실행

→ (2025.02.01 업데이트) 아래의 docker-compose.yml로 셋팅 완료 후 docker에서 ollama를 실행하는 것으로 대체됩니다. (PC에 Ollama를 별도로 설치할 필요 없음)

Docker 이미지 다운로드 및 컨테이너 실행

docker-compose.yml 작성

docker-compose.yml은 도커 이미지 다운로드 및 컨테이너 설정을 한 방에 완료할 수 있도록 도와주는 스크립트입니다. 파일명을 docker-compose로, 확장자를 yml인 문서를 생성한 후 아래의 내용을 복사 후 붙여넣기 하고 저장합니다.

또는, 첨부된 파일을 다운로드 해도 됩니다.

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

volumes:

- ollama:/root/.ollama

networks:

- llm-network

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "18080:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

restart: always

networks:

- llm-network

volumes:

ollama:

driver: local

open-webui:

driver: local

networks:

llm-network:

driver: bridgeDocker Compose 실행

키보드에서 '윈도우 키 + R'을 누른 후 "CMD"를 입력한 후 엔터를 칩니다. '명령 프롬프트'가 실행될 것입니다.

docker-compose.yml 파일을 생성한 경로로 이동합니다. 상단 폴더 경로를 클릭하면 전체 경로가 뜰 것입니다.

아래의 사진과 같이 파일이 있는 경로로 이동합니다. 예를 들어 파일이 있는 경로가 'C:\Users\pc\Documents\_ProjectFiles\_LLM' 이면, 아래와 같이 입력합니다.

cd C:\Users\pc\Documents\_ProjectFiles\_LLM

그리고 docker-compose up을 입력하여 설치 및 설정을 시작합니다.

이미지 다운로드 및 컨테이너가 잘 실행 되었다면, 위와 같이 뜰 것입니다. (그래픽카드 정상 인식 / Open WebUI 정상 실행) 위 창을 닫으면 컨테이너가 꺼집니다. (다시 켜면 됨)

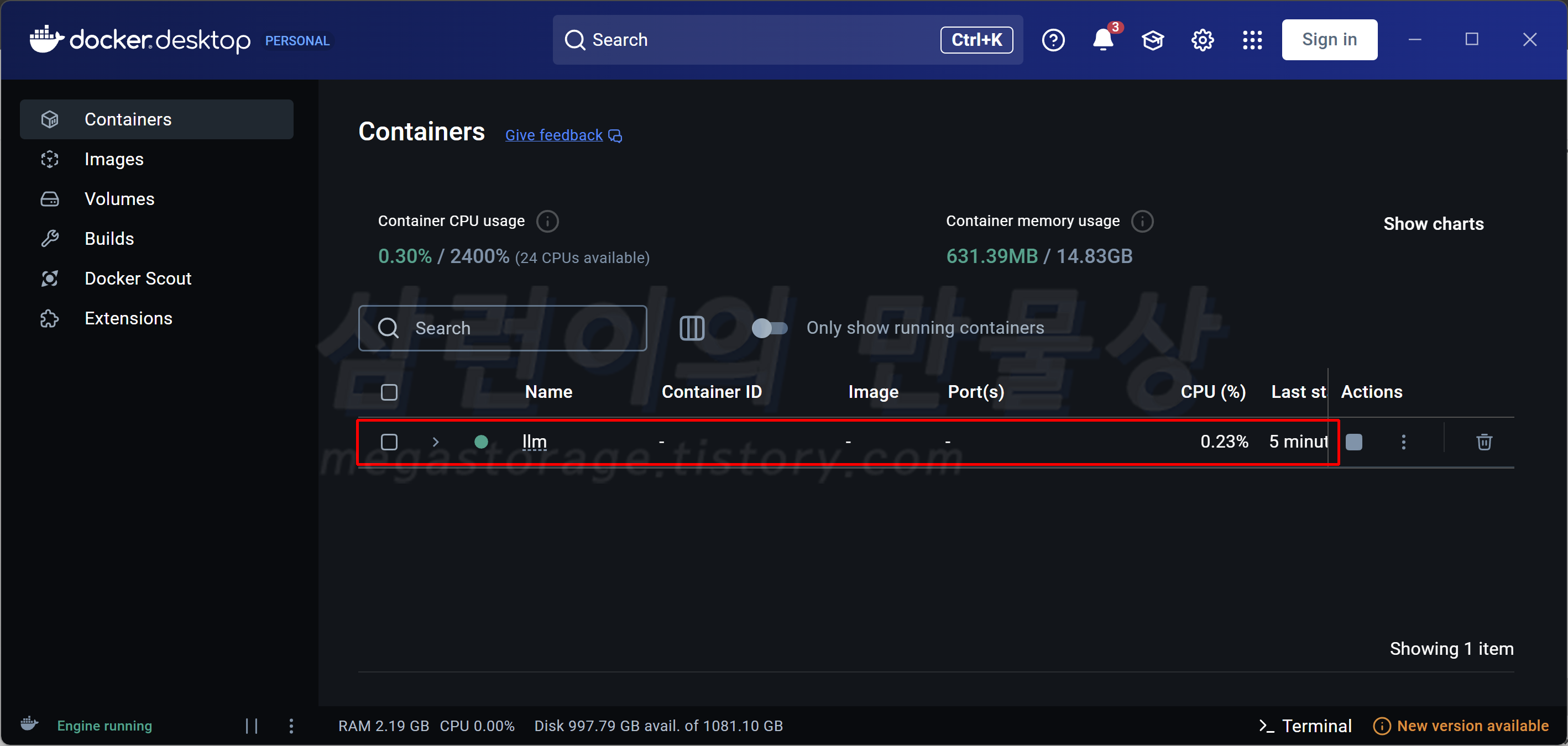

Docker Desktop의 컨테이너 탭에서 위와 같이 llm이 있어야 합니다.

llm을 선택한 후 들어갔을 때 위와 같이 ollama와 open-webui가 정상 실행된 상태여야 합니다. 마지막으로 open-webui의 포트 번호(18080:8080)을 누르면 Open WebUI 화면이 나타납니다.

DeepSeek 언어모델 다운로드

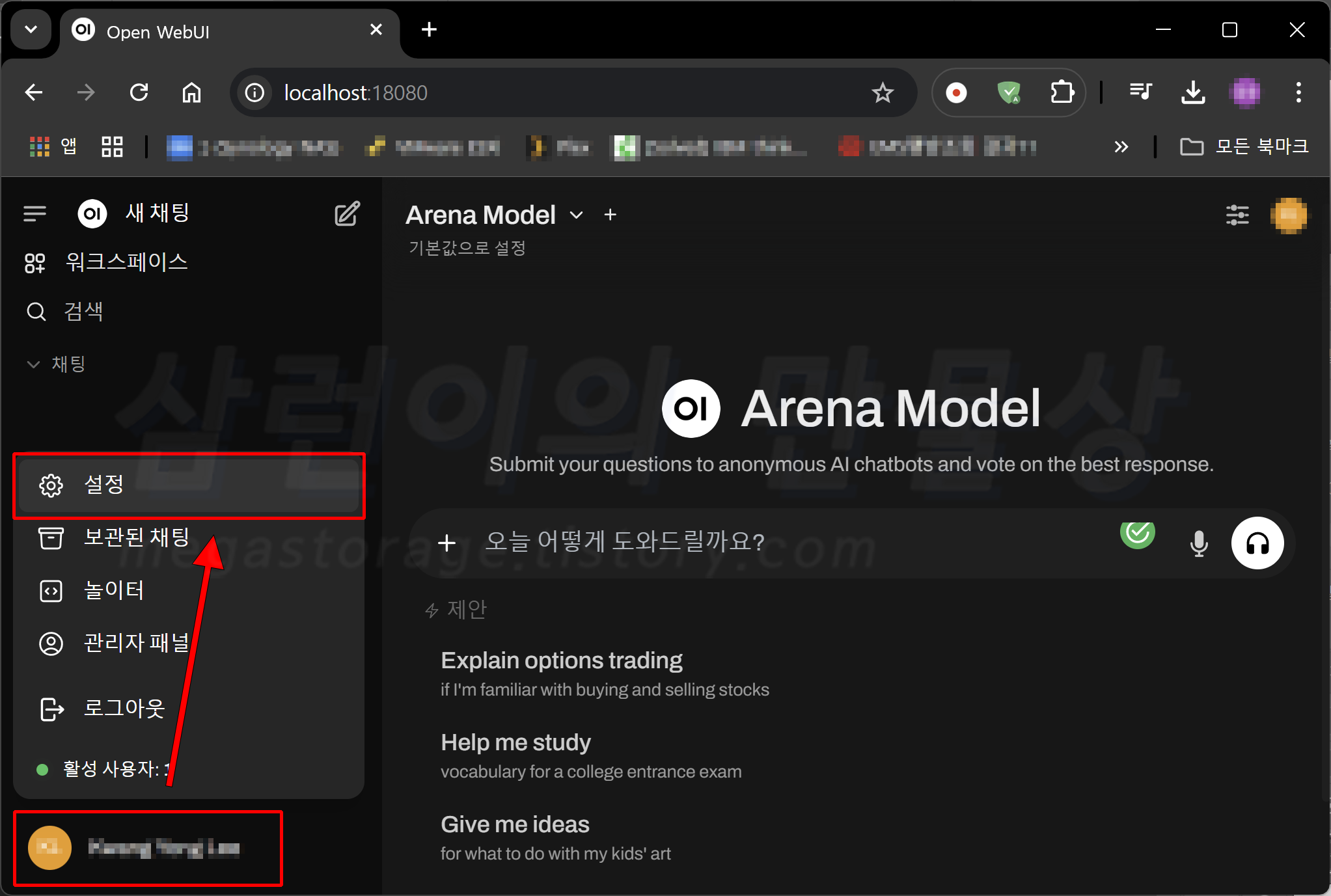

처음 접속을 하면 계정을 만들 것입니다. 계정 생성하면 위와 같은 화면을 볼 수 있는데, 좌측 하단의 '사용자 이름'을 선택한 후 '설정'을 선택합니다.

좌측의 '관리자 설정'을 선택합니다.

상단의 '모델'을 선택합니다. 저는 모델 2개를 설치한 상태라서 목록에 떠 있습니다. 우측의 내려받기 아이콘을 선택합니다.

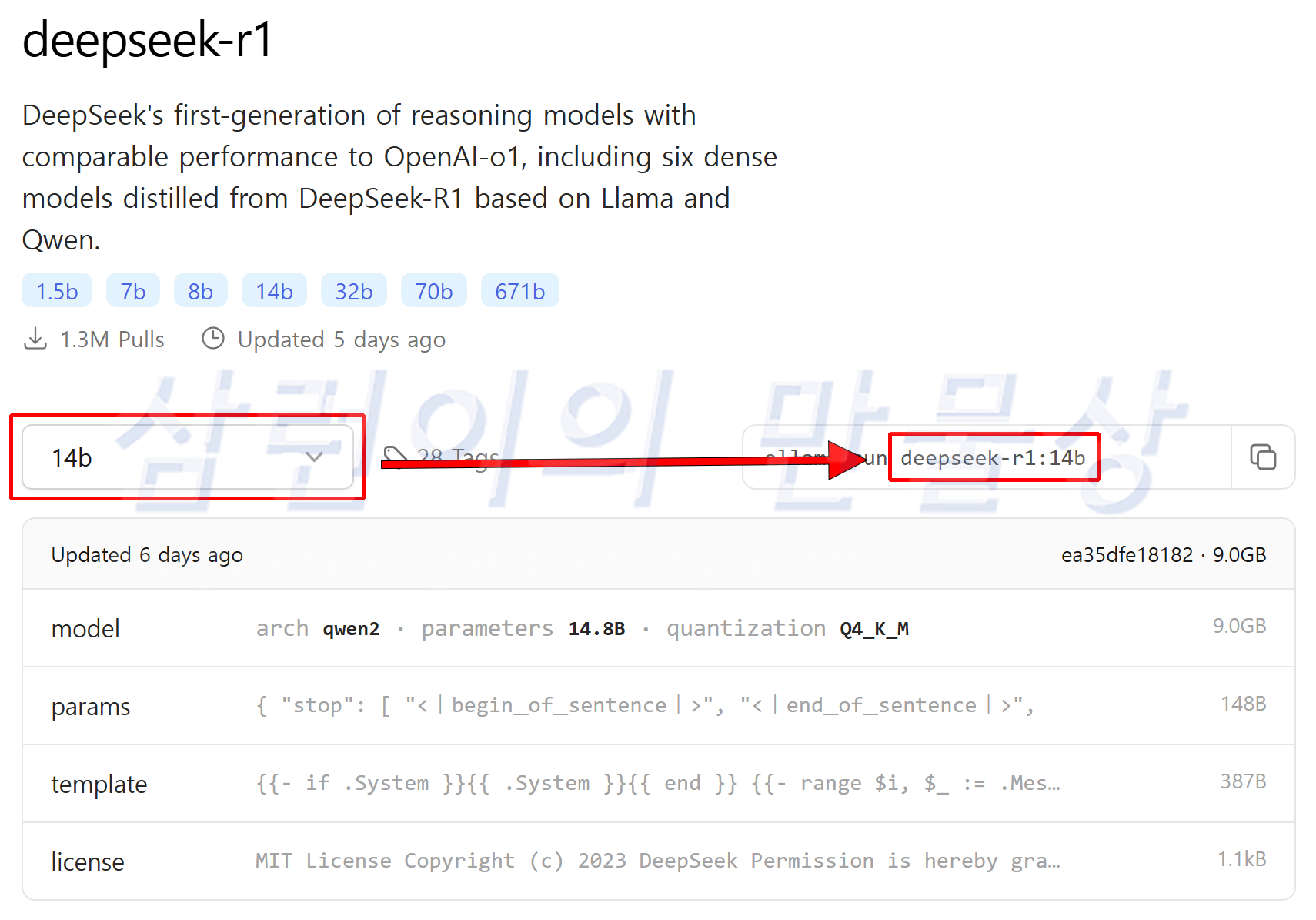

'Ollama.com에서 모델 가져오기(pull)'에 다운로드 받고자 하는 모델을 적습니다. 저는 DeepSeek-R1의 14b 모델을 다운받고 싶어서 'deepseek-r1:14b'를 입력했습니다. 정확한 모델명을 확인하는 방법은 아래의 링크에서 모델을 검색한 후 다운로드 가능한 모델의 '파라미터 크기'를 확인할 수 있습니다. ( https://ollama.com/library/deepseek-r1 ; deepseek-r1을 검색한 링크)

deepseek-r1

Get up and running with large language models.

ollama.com

DeepSeek-R1은 7가지의 파리미터 종류를 선택할 수 있습니다. 검색 후 들어갔을 때 기본 선택이 7b이며 우측의 명령어는 'deepseek-r1'만 표기되어 있습니다. ollama에서 deepseek-r1만 입력한 후 다운로드를 한다면 7b 버전이 다운로드 및 설정 되는 것입니다.

참고로 파라미터 크기가 클 수록 많은 VRAM(그래픽카드 메모리)이 필요합니다. 해당 모델들을 그래픽카드 메모리에 로드한 후 연산을 시작하기 때문입니다. 예전엔 1b당 2GB의 그래픽카드 메모리가 필요했고, 최근까지는 1b당 1GB의 그래픽카드 메모리가 필요했는데, 요즘은 1b당 필요한 그래픽카드 메모리가 점점 감소하는 추세입니다. (좋아지는 것) 사용 중인 그래픽카드 메모리의 용량보다 훨씬 큰 파라미터 크기를 가진 모델을 사용하는 경우, 질문에 대한 생각 과정과 대답 속도가 엄청 느려지는 문제가 발생하여 실사용이 불가할 수 있습니다.

14b 모델을 선택했을 경우엔 우측의 명령어가 'deepseek-r1:14b'로 표시됩니다. 즉, 원하는 언어 모델과 파라미터를 선택하는 과정은 아래와 같습니다.

언어모델이름:파라미터크기

다른 모델을 예시로 들자면, 한국어에 특화되었다는 LG의 언어 모델인 'exaone3.5( https://ollama.com/library/exaone3.5 )'는 총 3가지의 파라미터 종류를 선택할 수 있습니다. 2.4b / 7.8b / 32b 입니다.

exaone3.5

EXAONE 3.5 is a collection of instruction-tuned bilingual (English and Korean) generative models ranging from 2.4B to 32B parameters, developed and released by LG AI Research.

ollama.com

만약 2.4b 파라미터 모델을 다운로드 받고 싶다면? 'exaone3.5:2.4b'가 됩니다. 32b 파라미터 모델은? 'exaone3.5:32b'가 되겠죠. 이렇게 언어 모델의 이름을 찾고, 해당 모델의 파라미터 개수를 직접 설정한 후 다운로드 받으면 됩니다.

DeepSeek-R1 실제 사용 후기

우선 제 컴퓨터 사양은 아래와 같습니다.

- CPU : AMD 라이젠 AI 9 HX 370

- RAM : LPDDR5X-7500 32GB

- VGA : 엔비디아 지포스 RTX 4070 Laptop (VRAM 8GB)

- SSD : WD SN740 2TB (2230 사이즈)

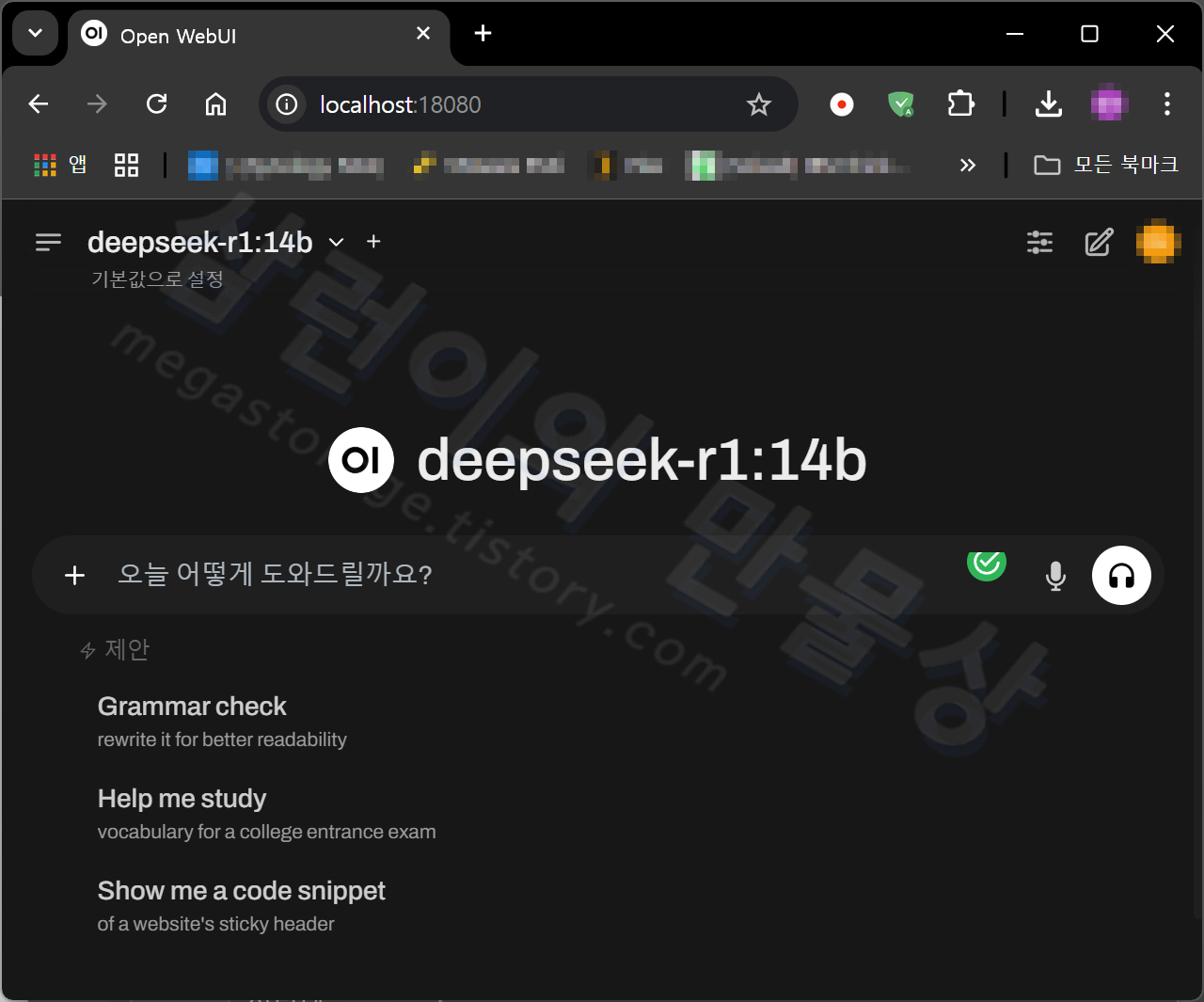

설치 완료 후 좌측 상단의 모델 선택 메뉴에서 'deepseek-r1'을 선택합니다. 저는 14b 파라미터 모델을 다운받았기 때문에 'deepseek-r1:14b'를 선택했습니다.

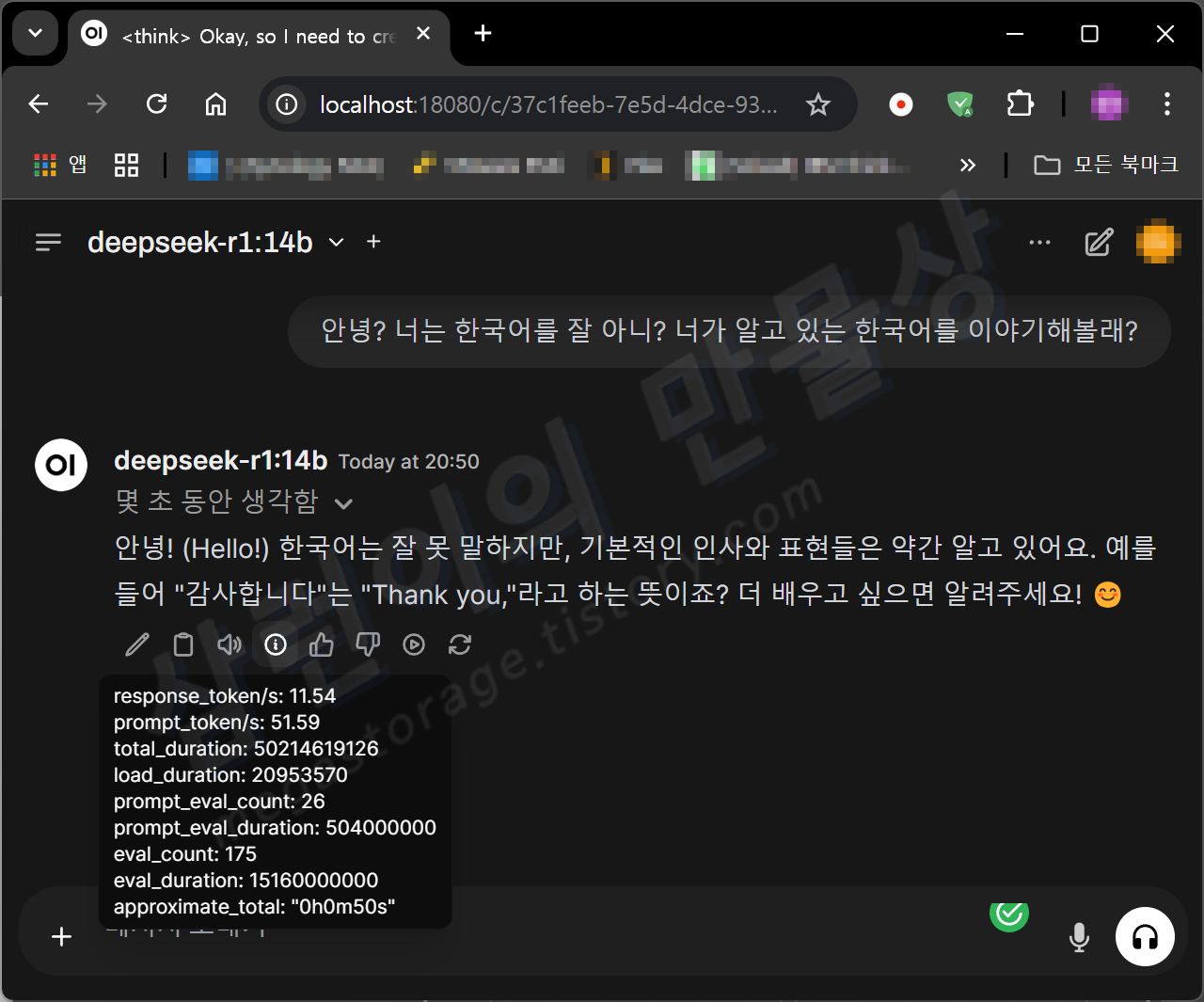

단순 한국어 입출력

"안녕? 너는 한국어를 잘 아니? 너가 알고 있는 한국어를 이야기해볼래?" 라고 물어봤습니다. 제가 다운로드 받은 DeepSeek-R1 14b 모델은 풀버전에 비해서 많이 칼질(양자화) 된 상태다보니, 영어가 아닌 한국어를 자연스럽게 하지 못할 것이란 우려가 있었습니다. 그런데 무난하게 잘 인식했고, 잘 출력되었습니다.

첫 실행이라서 시간이 다소 소요되었습니다. 전체 50초 걸렸습니다.

생각 및 출력할 때 CPU 사용률이 80~100% 수준을 유지했습니다. RAM 사용량이 갑작스럽게 증가했는데, VRAM 용량 초과로 인한 공유 메모리 사용으로 인한 것으로 보여집니다.

VRAM은 8GB 중 7.7GB를 사용했고, 이 용량보다 더 필요하여 시스템의 RAM을 2.7GB 사용했습니다. 그래서 총 10.4GB를 점유하고 있는 상태입니다.

이어서 "맞아! 너가 알고 있는 다른 한국어를 더 이야기 해줄래?" 라는 추가 질문을 했습니다. 답변 최종 출력까지 1분 3초가 소요된 이 내용은, 위 사진에서 보시다시피 한국어가 깨져서 나오기도 합니다. 구글 제미나이 유료 요금제에서 종종 보던 현상인데, 제가 다운로드 받은 DeepSeek-R1 모델은 심하게 양자화 된 14b 모델이라서 어쩔 수 없는 것으로 생각됩니다.

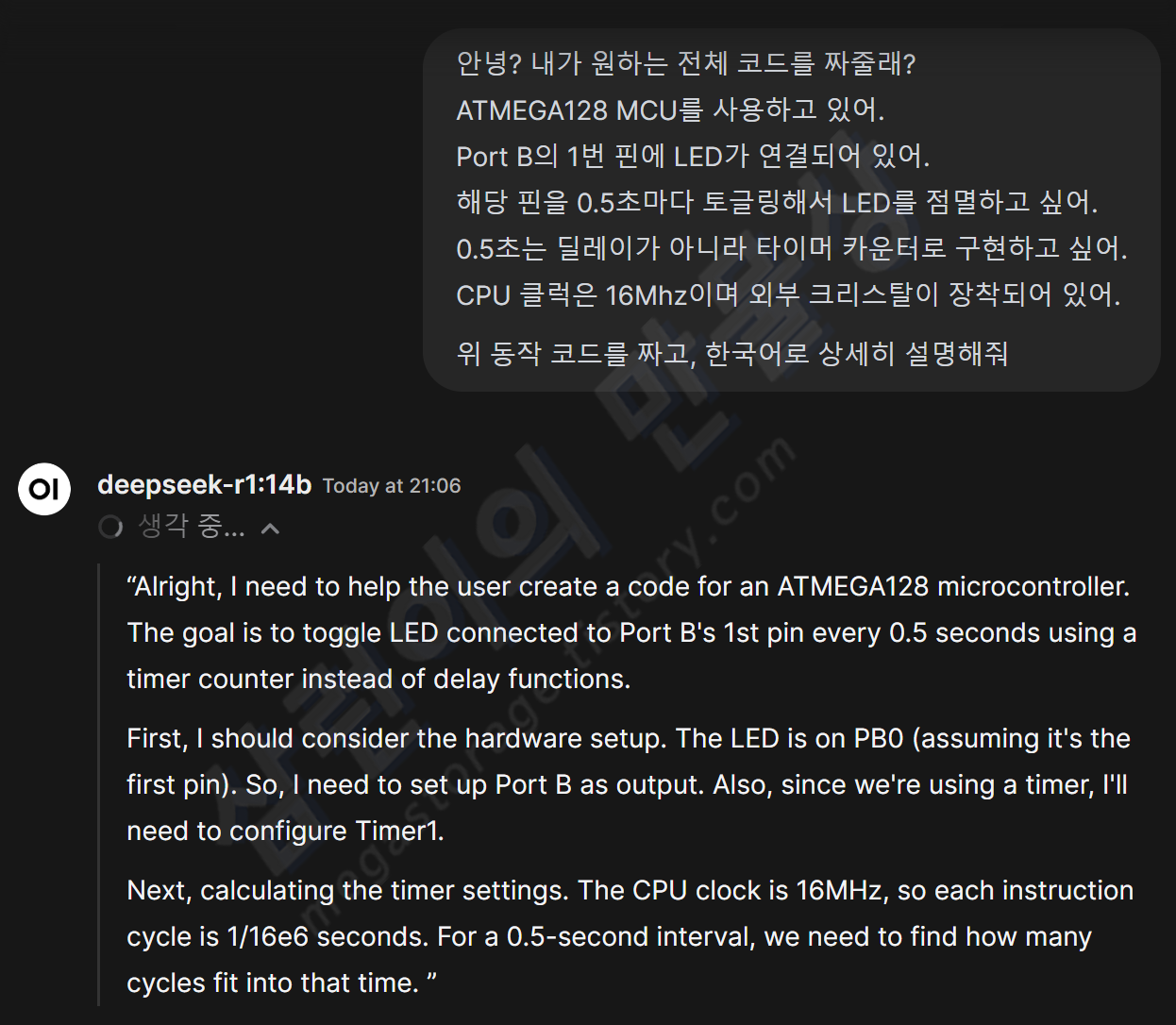

코드 작성 (임베디드/C언어)

코드를 짜달라고 해봤습니다. 조건과 환경을 제시했고, 한국어로 상세히 설명해달라고 주문했습니다. 생각은 영어로 합니다. 생각하는데 시간이 꽤 걸리네요. 생각이라는 것을 왜 하고, 시간이 왜 오래 걸리는지 내용을 보니까... "출력물에 대해서 스스로 잘못을 판단하고 여러번 수정하는 과정"이 있었습니다. 최대한 교정을 한 후 사용자에게 답변을 주는 것입니다.

5분 동안 생각한 후 나온 결과물입니다. 근데 무언가 잘못 되었습니다. 이 녀석이 영어로 설명을 해주네요. 정정을 요청해봅니다. "한국어로 설명해줘" 라고 입력했습니다.

매우 훌륭합니다. 부드러운 한국어 설명이 출력되었습니다. "언어" 라는 한자가 튀어 나왔지만, 괜찮습니다. 이 정도면 훌륭합니다.

장문 오류 내용 분석 및 해결방법 도출

아래는 제가 Yocto로 SDK 빌드 중 발생한 에러 로그입니다. 해결 방법을 찾고자 여기 저기 검색하던 도중에 DeepSeek-R1 14B에게 물어보기로 했습니다. (아래 '더보기' 누를 시 펼쳐집니다)

Sstate summary: Wanted 336 Local 0 Mirrors 0 Missed 336 Current 4656 (0% match, 93% complete) Removing 4 stale sstate objects for arch allarch: 100% |#########| Time: 0:00:00 Removing 1 stale sstate objects for arch edm_g_imx8mm: 100% |####| Time: 0:00:00 NOTE: Executing Tasks ERROR: nativesdk-xorgproto-2023.2-r0 do_configure: meson failed ERROR: nativesdk-xorgproto-2023.2-r0 do_configure: ExecutionError('/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/temp/run.do_configure.177904', 1, None, None) ERROR: Logfile of failure stored in: /home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/temp/log.do_configure.177904 Log data follows: | DEBUG: Executing python function extend_recipe_sysroot | NOTE: Direct dependencies are ['/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/meta-mingw/recipes-devtools/mingw-w64/nativesdk-mingw-w64-runtime_9.0.0.bb:do_populate_sysroot', '/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/gcc/gcc-crosssdk_13.3.bb:do_populate_sysroot', '/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/quilt/quilt-native_0.67.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/chrpath/chrpath_0.16.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/meson/meson_1.3.1.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/ninja/ninja_1.11.1.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/pseudo/pseudo_git.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/python/python3_3.12.6.bb:do_populate_sysroot', 'virtual:native:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-extended/xz/xz_5.4.6.bb:do_populate_sysroot', 'virtual:nativesdk:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-devtools/gcc/gcc-runtime_13.3.bb:do_populate_sysroot'] | NOTE: Installed into sysroot: [] | NOTE: Skipping as already exists in sysroot: ['nativesdk-mingw-w64-headers', 'nativesdk-mingw-w64-runtime', 'nativesdk-mingw-w64-winpthreads', 'gettext-minimal-native', 'binutils-crosssdk-i686-w64-mingw32', 'cmake-native', 'gcc-crosssdk-i686-w64-mingw32', 'libtool-native', 'm4-native', 'quilt-native', 'texinfo-dummy-native', 'openssl-native', 'expat-native', 'gettext-native', 'ncurses-native', 'util-linux-libuuid-native', 'zlib-native', 'chrpath-native', 'flex-native', 'gnu-config-native', 'libedit-native', 'make-native', 'meson-native', 'ninja-native', 'perl-native', 'pseudo-native', 'python3-build-native', 'python3-flit-core-native', 'python3-installer-native', 'python3-packaging-native', 'python3-pyproject-hooks-native', 'python3-setuptools-native', 'python3-wheel-native', 'python3-native', 'bzip2-native', 'libnsl2-native', 'libtirpc-native', 'unzip-native', 'xz-native', 'zstd-native', 'attr-native', 'gdbm-native', 'gmp-native', 'libffi-native', 'libmpc-native', 'mpfr-native', 're2c-native', 'sqlite3-native', 'nativesdk-gcc-runtime', 'nativesdk-libgcc'] | DEBUG: Python function extend_recipe_sysroot finished | DEBUG: Executing shell function do_configure | NOTE: Executing meson -Dlegacy=false... | The Meson build system | Version: 1.3.1 | Source dir: /home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/xorgproto-2023.2 | Build dir: /home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/build | Build type: cross build | Project name: xorgproto | Project version: 2023.2 | C compiler for the host machine: i686-w64-mingw32-gcc --sysroot=/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/recipe-sysroot (gcc 13.3.0 "i686-w64-mingw32-gcc (GCC) 13.3.0") | C linker for the host machine: i686-w64-mingw32-gcc --sysroot=/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/recipe-sysroot ld.bfd 2.42.0.20240723 | C compiler for the build machine: gcc (gcc 9.4.0 "gcc (Ubuntu 9.4.0-1ubuntu1~20.04.2) 9.4.0") | C linker for the build machine: gcc ld.bfd 2.34 | Build machine cpu family: x86_64 | Build machine cpu: x86_64 | Host machine cpu family: x86 | Host machine cpu: i686 | Target machine cpu family: x86 | Target machine cpu: i686 | Configuring applewmproto.pc using configuration | Configuring bigreqsproto.pc using configuration | Configuring compositeproto.pc using configuration | Configuring damageproto.pc using configuration | Configuring dmxproto.pc using configuration | Configuring dpmsproto.pc using configuration | Configuring dri2proto.pc using configuration | Configuring dri3proto.pc using configuration | Configuring fixesproto.pc using configuration | Configuring fontsproto.pc using configuration | Configuring glproto.pc using configuration | Configuring inputproto.pc using configuration | Configuring kbproto.pc using configuration | Configuring presentproto.pc using configuration | Configuring randrproto.pc using configuration | Configuring recordproto.pc using configuration | Configuring renderproto.pc using configuration | Configuring resourceproto.pc using configuration | Configuring scrnsaverproto.pc using configuration | Configuring videoproto.pc using configuration | Configuring xcmiscproto.pc using configuration | Configuring xextproto.pc using configuration | Configuring xf86bigfontproto.pc using configuration | Configuring xf86dgaproto.pc using configuration | Configuring xf86driproto.pc using configuration | Configuring xf86vidmodeproto.pc using configuration | Configuring xineramaproto.pc using configuration | Configuring xproto.pc using configuration | Configuring xwaylandproto.pc using configuration | Has header "sys/param.h" : YES | Has header "sys/types.h" : YES | Has header "sys/time.h" : YES | Has header "sys/select.h" : NO | Checking whether type "fd_set" has member "fds_bits" : NO | Checking whether type "fd_set" has member "__fds_bits" : NO | | ../xorgproto-2023.2/include/X11/meson.build:19:4: ERROR: Problem encountered: Your fd_set is too weird. | | A full log can be found at /home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/build-xwayland-edm-g-imx8mm/tmp/work/i686-nativesdk-mingw32-w64-mingw32/nativesdk-xorgproto/2023.2/build/meson-logs/meson-log.txt | ERROR: meson failed | WARNING: exit code 1 from a shell command. ERROR: Task (virtual:nativesdk:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-graphics/xorg-proto/xorgproto_2023.2.bb:do_configure) failed with exit code '1' NOTE: Tasks Summary: Attempted 2532 tasks of which 2521 didn't need to be rerun and 1 failed.

Summary: 1 task failed: virtual:nativesdk:/home/stanley/i.MX-8M-Mini_6.6.y-stable_YoctoProject/sources/poky/meta/recipes-graphics/xorg-proto/xorgproto_2023.2.bb:do_configure Summary: There were 2 ERROR messages, returning a non-zero exit code.

위 내용은 Yocto SDK 빌드하다가 오류난 로그야. 무엇이 원인인지 분석하고, 해결 방법을 한국어로 설명해줘.

이렇게 긴 내용을 단 1분 동안 생각한 후 답변을 출력했습니다. 이 답변을 전부 다 출력하기까지 3분 44초가 소요되었습니다. 중간에 알 수 없는 문자가 하나 포함되었지만, 매우 훌륭합니다.

여기까지 테스트 하다보니, 그래픽카드의 VRAM을 7.7GB, 시스템 메모리를 5.7GB 사용하여 총 13.5GB 메모리를 쓰고 있습니다. VRAM 용량 초과되어 전체 점유율의 절반 정도를 시스템 메모리가 차지한 것 치고는 답변 속도가 매우 빠릅니다.

마무리

지금까지 2025년 새해부터 전세계에 충격과 공포를 안겨준 DeepSeek의 대규모 언어 모델인 DeepSeek-R1 14B 모델을 사용하기 위한 방법을 안내해드렸습니다. 이 정도면 마음 놓고 써도 되겠습니다. (로컬 기준. 온라인 버전은 잘 생각하고 써야합니다)

잘 안되거나 궁금한 점 있으시면 댓글 달아주세요. 감사합니다. :)

'★3. 삼런이의 [테크니컬]' 카테고리의 다른 글

| [배터리] 아이폰 애플스토어 정품 배터리 교체 및 배터리 효율 성능의 진실 (feat. iPhone 13 mini) (2) | 2025.02.09 |

|---|---|

| [꿀팁] 갤럭시 탭 태블릿 PC를 휴대용 포터블 모니터로 사용하기 (세컨드 스크린/Second Screen) (0) | 2024.11.02 |

| [카드] 네이버 페이 머니 카드 - 3개월 사용기 (해외결제 최강 체크카드) (1) | 2024.09.22 |

| [IoT] Home Assistant 서버 구축 - SmartThings 연동 (0) | 2024.08.05 |

| [IoT] Home Assistant 서버 구축 - HTTPS 및 리버스 프록시 설정 (1) | 2024.08.04 |